Der menschliche Hörsinn ist ein hochentwickeltes System: Wenn wir einem Gespräch folgen wollen, können wir störende Hintergrundgeräusche ausblenden. Gleichzeitig nehmen wir alarmierende Geräusche selbst bei Lärm sofort wahr. Wir können ziemlich gut vorhersagen, aus welcher Richtung ein Geräusch kommt und wie weit entfernt die Schallquelle ist. Und das alles mit nur zwei Ohren als Schallempfänger. Der größte Teil der Leistung liegt dabei zwischen den Ohren. Um auch Computern das Hören beizubringen, entwickeln Wissenschaftler der Projektgruppe Hör-, Sprach- und Audiotechnologie des Fraunhofer IDMT in Kooperation mit der Grundlagenforschung an der Universität Oldenburg Rechenmodelle, die den menschlichen Hörsinn simulieren. Die Anwendungsfelder für die Technologie reichen von Smart Home und Smart City bis zu Industrie 4.0. Interview mit Dr.-Ing. Stefan Goetze

Herr Goetze, in Ihrer Forschungsgruppe bringen Sie Computern das Hören bei – wie machen Sie das?

Basis unserer Arbeit sind Computermodelle, die die menschliche Hörwahrnehmung simulieren. Anhand von Algorithmen, die Sprache und Geräusche beschreiben, entwickeln wir Verfahren des Maschinen-Lernens, um Computern das Erkennen von akustischen Ereignissen beizubringen. Unsere Erkennersysteme werden mit vielen Stunden Audiomaterial trainiert. Das Audiosignal wird dafür in sogenannte akustische Merkmale umgewandelt, die der Computer dann als Muster wiedererkennt. In unserer Projektgruppe haben wir eine Datenbank mit hunderten unterschiedlicher Merkmale aufgebaut,die auf Erkenntnissen der Grundlagenforschung über das Hören basieren. Für die computerbasierte Mustererkennung wenden wir sowohl statistische Verfahren als auch Methoden der künstlichen Intelligenz an.

Wie gut funktionieren diese Verfahren?

Mithilfe sogenannter künstlicher neuronaler Netzwerke − also Algorithmen, die die Verarbeitung von Signalen im menschlichen Gehirn nachbilden − erreichen wir bisher die besten Erkennungsergebnisse. Bei der Erkennung von nichtsprachlichen akustischen Ereignissen kommen wir an die menschliche Erkennungsleistung heran. Die liegt allerdings auch beim Menschen nur bei etwa 80 Prozent, wenn der optische Sinn nicht hinzugezogen wird. Bei der Spracherkennung muss die Erkennerleistung bei etwa 95 Prozent liegen, damit die Performanz akzeptabel ist. Noch wichtiger ist allerdings die Vermeidung von Falscherkennungen: wenn beispielsweise die Spracherkennung im Smart Home ein Schnarchen fehlinterpretiert und daraufhin das Licht angeschaltet wird, geht die Akzeptanz für ein solches technisches System gegen Null.

Vor allem bei Umgebungslärm oder wenn das Mikrofon zu weit vom Sprecher entfernt ist, arbeiten Spracherkennungssyteme aber oft nicht zuverlässig – das Problem kennt jeder, der die Spracherkennung in seinem Smartphone oder im Navigationsgerät im Auto nutzt. Wie kann das verbessert werden?

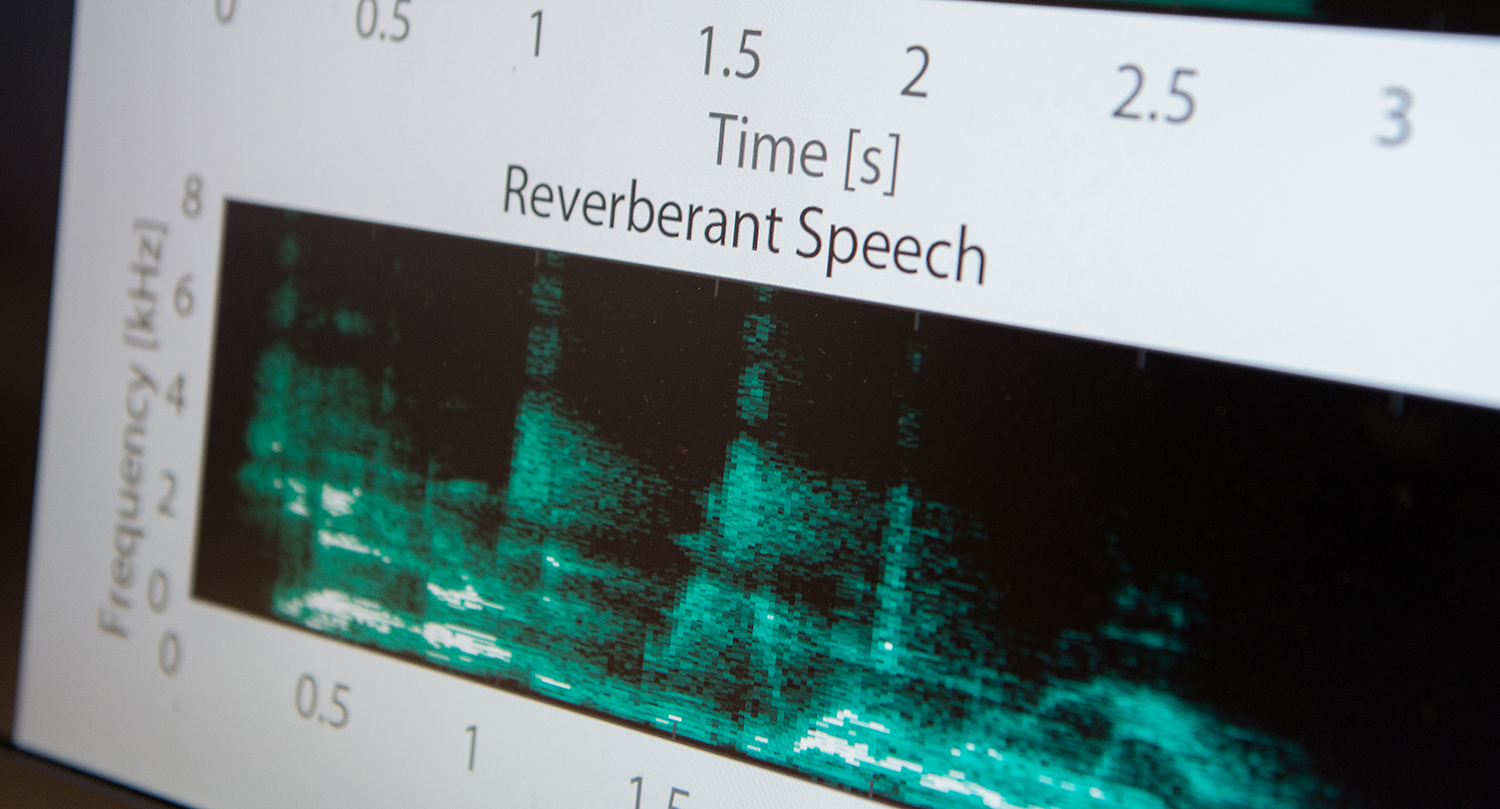

Raumhall und Störgeräusche können die Wahrnehmung von Sprache und Musik erheblich beeinflussen. Das Problem besteht auch bei computerbasiertem Hören. Jeder Raum hat andere akustische Eigenschaften, die den Klang unvorhergesehen verändern können. Ein Forschungsschwerpunkt unserer Gruppe sind Algorithmen, die in Echtzeit Nachhall und Störgeräusche reduzieren, um die Verständlichkeit von Sprache zu verbessern. Durch intelligente Signalvorverarbeitung funktionieren Systeme zur automatischen Sprach- und Ereigniserkennung deutlich robuster. Unsere Algorithmen sind in der Lage, Sprache und definierte akustische Ereignisse von Hall und Störgeräuschen zu unterscheiden und herauszufiltern.

Der Mensch hat zwei Ohren – wie viele Mikrofone benötigt ein Computer zum „Hören“?

Um räumlich hören zu können, sind mindestens zwei Schallempfänger nötig. Das menschliche Gehirn berechnet den Zeitversatz und den Intensitätsunterschied zwischen den Schallwellen, die am linken und rechten Ohr eintreffen, um eine Geräuschquelle verorten zu können. Wenn räumliche Informationen für den Erkennungsprozess wichtig sind, verwenden wir mehrere Mikrofone, sogenannte Mikrofon-Arrays. Je nach Anwendungsszenario setzen wir winzig kleine und auch bis zu hundert Mikrofone ein. Anhand dieser Schallquellen kann auch ein Computerprogramm zum Beispiel erkennen, aus welcher Richtung gesprochen wird und Geräusche aus anderen Richtungen unterdrücken. Diese Methode nennt man „Beamforming“. Mit Beamforming ist es möglich, auf eine Geräuschquelle zu fokussieren und sie heran zu zoomen.

Herr Goetze, wozu bringen Sie Computern das Hören bei?

Akustische Sprach- und Ereigniserkennung kann in unterschiedlichsten Technologien eingesetzt werden, die wir im Alltag nutzen – von der Spracherkennung im Smartphone oder im Smart Home über Sicherheitsanwendungen in Smart Cities bis zum akustischen Monitoring von Produktionsmaschinen. Eines unserer ersten Projekte war die akustische Unterscheidung von trockenem und produktivem Husten. Dann haben wir zusammen mit Industriepartnern intelligente Notrufsysteme für die stationäre und häusliche Pflege entwickelt, die nicht nur Hilferufe, sondern auch kritische Ereignisse wie Wimmern oder zerbrechendes Glas akustisch erkennen. Im Rahmen von internationalen Forschungsprojekten haben wir seitdem das Potenzial dieser Technologie in unterschiedlichen Szenarien weiter untersucht: beispielsweise in Smart Cities im Verkehrs-Monitoring oder zur Detektion von sicherheitskritischen Ereignissen. Aktuell beschäftigen wir uns mit dem Potenzial von akustischen Erkennersystemen in Industrie 4.0-Szenarien.

Fraunhofer-Institut für Digitale Medientechnologie IDMT

Fraunhofer-Institut für Digitale Medientechnologie IDMT